Thinking Machines Lab ha pubblicato il suo primo post sul blog: Defeating Nondeterminism in LLM Inference

È un lavoro che affronta di petto uno dei problemi più sottovalutati dell’intelligenza artifi

Thinking Machines Lab ha pubblicato il suo primo post sul blog: Defeating Nondeterminism in LLM Inference. È un lavoro che affronta di petto uno dei problemi più sottovalutati dell’intelligenza artificiale: la riproducibilità.

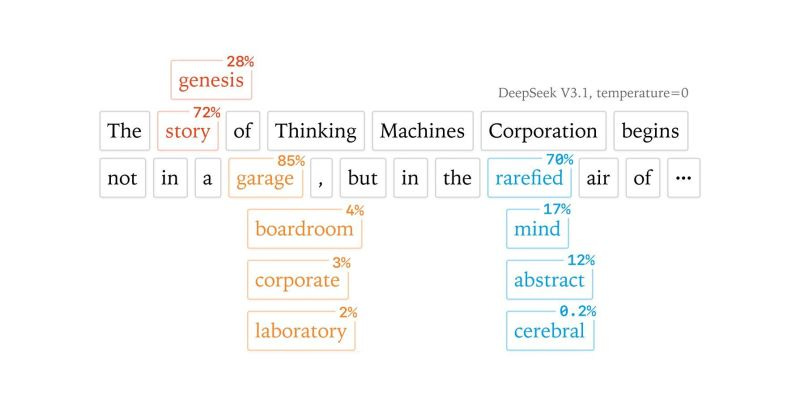

Chi usa i modelli linguistici sa bene che non sempre danno la stessa risposta. Anche facendo la stessa domanda due volte, si ottengono risultati diversi. La cosa sorprendente è che questo succede anche quando il modello dovrebbe essere “deterministico”, cioè restituire sempre la stessa risposta.

Finora si è pensato che la causa fossero le GPU o piccoli errori di calcolo. In realtà, come dimostra l’analisi di Horace, il vero problema è un altro: il risultato può cambiare semplicemente in base a quante altre richieste arrivano al server nello stesso momento.

Il lavoro di Thinking Machines mostra come risolvere il problema, permettendo finalmente di avere risposte identiche e ripetibili. Questo significa poter costruire ricerca più affidabile, applicazioni aziendali davvero solide e risultati scientifici verificabili.

È un passaggio fondamentale per portare l’intelligenza artificiale a uno stadio di maggiore maturità e credibilità. Per chi lavora nel settore, è davvero un prima e un dopo.

Leggi il paper rivoluzionario: https://thinkingmachines.ai/blog/defeating-nondeterminism-in-llm-inference/