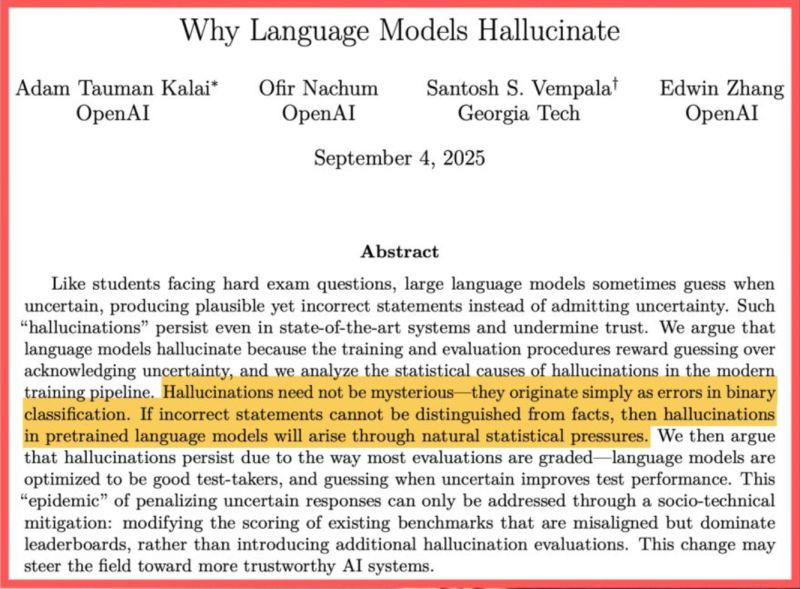

OpenAI ha appena spiegato perché gli LLM “allucinano” … e il motivo ricorda da vicino quello che succede in sanità

La verità è questa: i modelli non si inventano cose perché “non funzionano”, ma perché li abbiamo addestrati a farlo.

👉 Durante la fase di addestramento iniziale (pre-training), il modello deve inventare quando i dati non ci sono (se chiedi la data di nascita di una persona sconosciuta, non può risponderti “non lo so”: è spinto a tirare a indovinare).

👉 Con il post-training (addestramento migliorativo) peggioriamo le cose: benchmark e classifiche varie puniscono allo stesso modo sia un “non lo so” che una risposta sbagliata.

👉 Il risultato è che creiamo modelli bravissimi a sembrare sicuri, ma non necessariamente a dire la verità.

Se il tabellone premia la sicurezza apparente invece dell’onestà, il risultato sarà prevedibile: più errori, più costi, meno fiducia.

La soluzione?

✅ Premiare l’onestà (“non lo so”) invece del bluff.

✅ Penalizzare più le risposte sicure ma sbagliate che non quelle incerte.

✅ Creare metriche che tengano conto del valore dell’incertezza.

Un modello che ogni tanto ammette “non lo so” può sembrare meno brillante nei ranking, ma nel mondo reale… è proprio quel tipo di modello che ci serve per fidarci davvero.

Questa potrebbe essere la prossima grande svolta dell’AI: insegnare all’AI ad essere onesta.

Paper: https://cdn.openai.com/pdf/d04913be-3f6f-4d2b-b283-ff432ef4aaa5/why-language-models-hallucinate.pdf